最近,中国科学院院士、中国科学技术大学教授郭光灿团队的李传锋、黄运锋、崔金明等人利用机器学习算法,在现场可编程门阵列(FPGA)上同时实现了离子量子比特的快速、高保真度读取。该团队在囚禁离子量子态读取方面取得了新进展。7月22日,该项研究成果被发表在应用物理期刊 PhysicalReviewApplied 上。

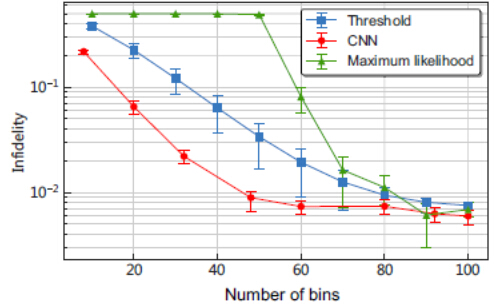

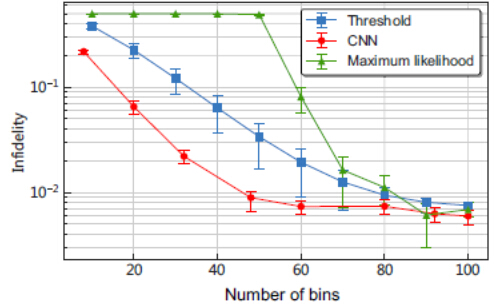

离子阱可以稳定地囚禁离子阵列,离子之间的库仑力提供了长程相互作用,是量子信息研究的理想实验平台。实现可容错量子计算需要高质量的量子操作,其中包括高保真度量子逻辑门和量子比特量子态读取,因此实现快速、高保真度量子态读取具有重要意义。在离子阱系统中,一般采用离子荧光探测的方法获得一段时间内的光子计数,通过阈值甄别的方法判断离子处于“亮”或“暗”态,这种方法获得的信息较少,不能达到较高的保真度。

李传锋研究组提出了利用机器学习算法分析光子到达探测器时间序列的方法来甄别离子态。相比阈值甄别,可以在更短的时间内获得更高的保真度。为了实现对离子态的快速实时读取,研究组进一步在现场可编程门阵列(FPGA)硬件上编程,并运行机器学习算法,在总时间170微秒内对Yb171离子读取保真度大于99.5%,其中包含了荧光探测时间和硬件算法运行时间。

该工作研发的硬件容易进一步开发成功能模块,可以应用于现有离子或者原子荧光态读取实验体系上,从而在不改变其他实验条件的前提下,提高量子态读取的速度和保真度。

论文第一作者是中科院量子信息重点实验室本科生丁子涵。上述研究得到科技部、国家基金委、中科院和安徽省的支持。

中国科大实现囚禁离子量子态快速高保真度读出